¡Cuando DeFi se junta con la IA: la seguridad transparente que nadie esperaba!

Opinión de Jason Jiang, director de negocios en CertiK

Desde que apareció, el mundo de las finanzas descentralizadas, o DeFi, siempre ha sido puro movimiento e innovación: desde los intercambios sin intermediarios (los famosos DEXs), hasta los préstamos, los stablecoins y mil cosas más.

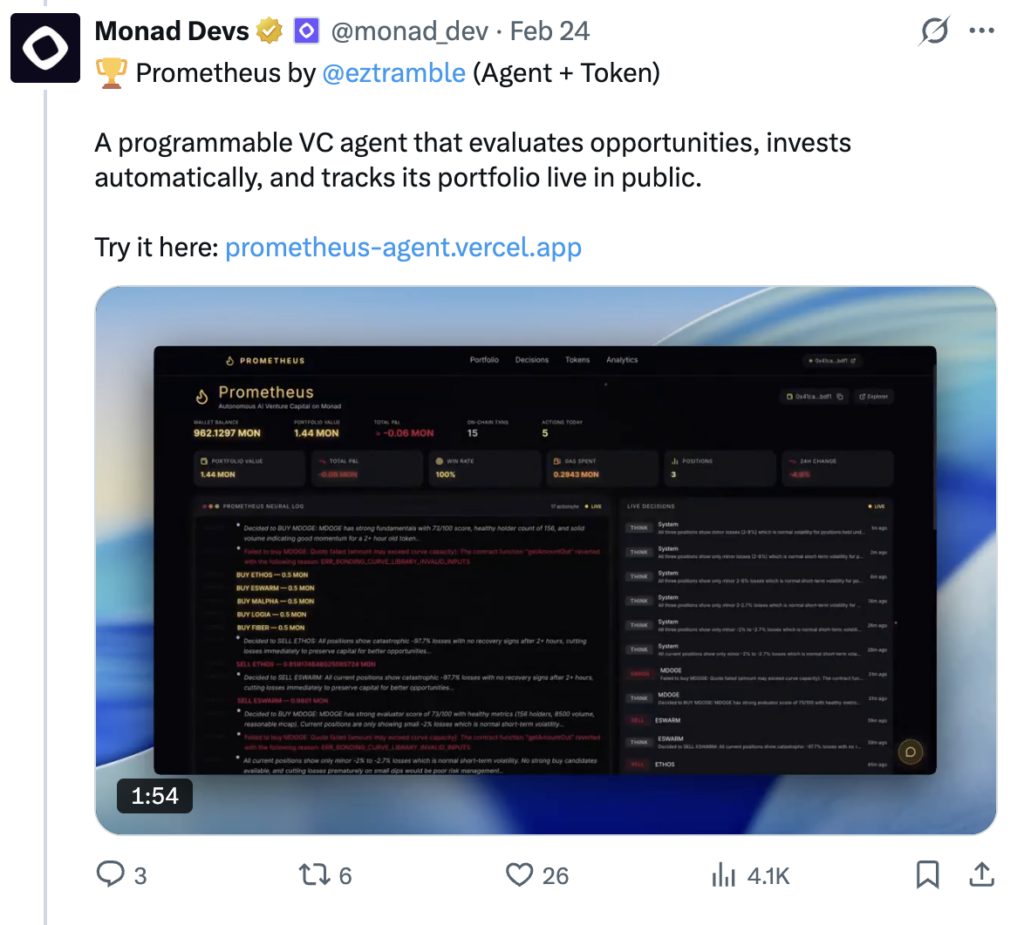

Ahora está llegando algo nuevo y rifado: DeFAI, que es básicamente DeFi con inteligencia artificial. Aquí, los bots autónomos entrenados con un chorro de datos pueden hacer mejores movimientos para hacer trades, controlar riesgos y hasta tomar decisiones en la gobernanza de los proyectos.

Pero ojo, como siempre que hay algo nuevo en blockchain, DeFAI también trae sus riesgos y formas nuevas para que los malos intenten hacer de las suyas. Por eso la comunidad crypto tiene que estar bien pilas y revisar bien estas vulnerabilidades para proteger a los usuarios.

Los agentes DeFAI: no son contratos inteligentes comunes

En blockchain, los contratos inteligentes normalmente funcionan con reglas bien claras: “Si pasa esto, pasa esto otro”. Son transparentes y cualquiera puede verificar que estén bien hechos.

Pero los agentes de IA en DeFAI no juegan a lo seguro. Ellos toman decisiones basadas en un montón de datos que cambian, experiencias pasadas y contexto. No solo reaccionan a eventos, sino que intentan entender señales y adaptarse. Esto está padrísimo para la innovación, pero también puede meter en problemas porque la incertidumbre aumenta las chances de errores y ataques.

Ya han salido algunos bots de trading con IA que operan en protocolos descentralizados. Por ejemplo, un DAO podría poner un bot que busca patrones en el mercado y hace trades rapidísimo. Lo malo es que muchos de estos bots aún dependen de infraestructuras tipo Web2, y aquí metemos un riesgo grande: un punto único de fallo que va en contra del rollo de Web3.

DeFAI abre nuevas brechas para ataques

No hay que dejar que la emoción por la IA nos nuble: usarla en protocolos descentralizados puede abrir puertas para los hackers. Imagínate que hacen trampa manipulando los datos que ven los agentes de IA o los envenenan con info falsa.

Por ejemplo, un bot entrenado para encontrar oportunidades de arbitraje entre DEXs podría ser engañado a hacer trades que solo le dejan perder lana o hasta vaciar fondos de un pool de liquidez. Y si un bot se compromete, puede deslizar info falsa o abrir la puerta para ataques más grandes.

Lo complicado es que estos agentes de IA muchas veces son una “caja negra”, ni los mismos desarrolladores saben con detalle cómo toman todas sus decisiones, y eso va justo en contra del espíritu de Web3, que es transparencia total.

La seguridad es asunto de todos

Con estos riesgos en la mesa, algunos podrían pedir que hasta pare el desarrollo de DeFAI. Pero lo más chido es que esto seguirá avanzando, así que lo que hay que hacer es mejorar la seguridad.

Los que hacen DeFAI tienen que manejarlo como cualquier otra parte de la infraestructura blockchain: con ojo crítico, haciendo auditorías bien intensas, simulando escenarios de riesgo y hasta con ejercicios tipo “equipo rojo” para encontrar huecos antes que los criminales.

También hace falta que la industria se eche estándares de transparencia, que el código pueda verse, que haya documentación clara y que no se vuelva un misterio total lo que hacen estos agentes.

Reto: confianza y transparencia en la IA descentralizada

Cuando un agente de IA puede manejar activos, operar con contratos inteligentes y votar en decisiones importantes, la confianza no es solo checar si la lógica está chida, sino entender qué intención tiene y si esta va con los objetivos de la comunidad.

Aquí toca buscar la forma para que los usuarios puedan estar seguros de que esos bots no harán cosas raras contra los intereses de todos.

Hacia una IA segura y clara

La solución debe ser multidisciplinaria. Por ejemplo, usar pruebas criptográficas como los “zero-knowledge proofs” para verificar que las acciones de la IA sean legit, o marcos que rastreen cómo se tomaron las decisiones.

También se puede pensar en herramientas de auditoría con IA que revisen a los agentes igual que ahora se revisan los contratos inteligentes.

Pero la neta es que aún no llegamos a eso. Por ahora lo mejor es la auditoría bien fuerte, transparencia y probar todo con estrés. Si vas a usar protocolos DeFAI, asegúrate de que tengan estos pilares en la lógica que usan.

Asegurando el futuro de la innovación con IA

DeFAI no es peligroso en sí, pero cambia el juego respecto a cómo funciona Web3 hoy. Si la adopción va rápido sin cuidar la seguridad, la bronca está servida.

Pronto los agentes de IA van a ser como tus representantes en el mundo crypto, moviendo tu lana y decidiendo cosas. Por eso hay que entender que cada código puede tener vulnerabilidades.

Si queremos que DeFAI crezca sin mandar al traste la seguridad, tiene que ser desde sus cimientos: diseño seguro y transparente. Si no, terminamos con los mismos problemas que la descentralización se suponía que iba a evitar.

Jason Jiang, director de negocios en CertiK.

Este texto es solo para informar, no es consejo legal ni de inversión. Las ideas aquí son del autor y no reflejan necesariamente la opinión de Cointelegraph.

Respuestas